DevOps, “development” ve “operations” kelimelerinin bir araya getirilmesinden oluşmuş bir kelime. Yani, “geliştirme” ve “operasyon”. Burada “geliştirme” dediğimiz zaman yazılım geliştirilmesinden, operasyon derken de, bu yazılımın çalıştırılması ve kullanımından bahsediyoruz.

Geliştirme, yazılımcılar tarafından yapılır. Yazılımcılar genellikle, kendi güvenli alanlarından, yani kod yazma alanından dışarıya çıkmak istemezler. Kod hangi makinada çalışacak, oralara nasıl kopyalanacak, çalışma sırasında ne problemler çıkacak gibi sorunlara ilgi göstermek istemezler. Gösterirlerse de, bundan çok hoşlanmazlar.

İşte bu noktada müşteri memnuniyetini artırmak için daha farklı etmenler devreye giriyor. Sisteminizin iyi çalışmasını sağlamak için ise geliştiricilerinizin, test edenlerin ve çalışanlarınızın, kısaca bütün ekibinizin yüksek doğruluk oranlı hata izleme ve öngörme yetenekleri olması gerekir. Ancak daha en başından sisteminizi test etmek gelecekte karşılaşacağınız sorunları en aza indirgemekte önemli bir yer tutuyor. Bununla birlikte işletmeniz için doğru test aracını bulmak bir hayli zor ve zaman alan bir süreç olabilir.

Peki bu süreci kolaylaştıran yazılımlar neler? Bu yazımızda işinizi kolaylaştıracak 8 yazılımı bir araya getirdik;

1- XL TestView

XL TestView bir test yönetim ve analiz aracıdır ve yapmak istediğiniz testleri tanımlayıp yürütmenize olanak verir. Daha sonra sonuçları bir araya toplamına ve görselleştirmenize olanak verir.

1- XL TestView

XL TestView bir test yönetim ve analiz aracıdır ve yapmak istediğiniz testleri tanımlayıp yürütmenize olanak verir. Daha sonra sonuçları bir araya toplamına ve görselleştirmenize olanak verir.

2- Selenium

Selenium, web uygulamalarınız için taşınabilir bir test sistemidir. Ayrıca Java, C#, Groovy, Perl, Python ve Ruby gibi popüler programlama dillerinde testler yazmanız için de bir dil desteği sağlar.

Selenium, web uygulamalarınız için taşınabilir bir test sistemidir. Ayrıca Java, C#, Groovy, Perl, Python ve Ruby gibi popüler programlama dillerinde testler yazmanız için de bir dil desteği sağlar.

3- Cucumber

Cucumber bilgisayar programcılarının başka yazılımları test etmek için kullandığı bir yazılımdır. BDD (Behavior-driven development) tarzı otomatikleştirilmiş kabul testleri çalıştıran bir program. Ruby dilinde yazılmış olsa da Ruby haricindeki platformlarda kullanılabilir.

Cucumber bilgisayar programcılarının başka yazılımları test etmek için kullandığı bir yazılımdır. BDD (Behavior-driven development) tarzı otomatikleştirilmiş kabul testleri çalıştıran bir program. Ruby dilinde yazılmış olsa da Ruby haricindeki platformlarda kullanılabilir.

4- Appium

Appium doğal, hibrit ve mobil uygulamalar ile kullanabileceğiniz açık kaynak kodlu bir test otomasyon sistemi. WebDriver protokolünü kullanarak IOS ve Android uygulamalarını yürütüyor.

Appium doğal, hibrit ve mobil uygulamalar ile kullanabileceğiniz açık kaynak kodlu bir test otomasyon sistemi. WebDriver protokolünü kullanarak IOS ve Android uygulamalarını yürütüyor.

5- JMeter

Apache JMeter Web odaklı birçok farklı servisi test etmekte kullanabileceğiz bir apache projesi.

Apache JMeter Web odaklı birçok farklı servisi test etmekte kullanabileceğiz bir apache projesi.

6- JUnit

JUnit java dili için bir ünite test sistemi. Daha önceden SUnite dayanan xUnit olarak da biliniyordu.

JUnit java dili için bir ünite test sistemi. Daha önceden SUnite dayanan xUnit olarak da biliniyordu.

7- FitNesse

FitNesse bir web sunucusu, bir wiki ve otomaikleştirilmiş bir test aracı. Ward Cunningham’ın Framework for Integrated Test yazılımına dayalı. FitNesse ünite testinden ziyade kabul testleri için tasarlandı ve sistem işlevinin detaylı okunabilir tanımlamasını sağlayabiliyor.

FitNesse bir web sunucusu, bir wiki ve otomaikleştirilmiş bir test aracı. Ward Cunningham’ın Framework for Integrated Test yazılımına dayalı. FitNesse ünite testinden ziyade kabul testleri için tasarlandı ve sistem işlevinin detaylı okunabilir tanımlamasını sağlayabiliyor.

8- Gatling

Gatling, Scala, Akka ve Netty’e dayanan bir yük test sistemi. Web uygulamaları başta olmak üzere farklı servislerin performansını ölçme ve analiz etmekte kullanılabilir.

Gatling, Scala, Akka ve Netty’e dayanan bir yük test sistemi. Web uygulamaları başta olmak üzere farklı servislerin performansını ölçme ve analiz etmekte kullanılabilir.

şeyler kötü gittiğinde – ki bu noktada danışmanlık almaya daha eğilimliyizdir- önceden de kötü giden şeyleri hatırlamaya başlarız. BT danışmanlarına bazen, müşterileri çalışmalarından hiç memnun olmamış gibi gelir. Bu durum motivasyon kaybı yaratması sebebiyle çalışmaların da tam bir başarıya ulaşması konusunda bir engeldir. İnsan doğası iyi giden şeyleri hatırlamakta güçlük çeker. Böyle durumlara hazırlıklı olmakla birlikte, işinize hakim olduğunuzu hissettirin, soğukkanlı olun ve kimseyi suçlayıcı şekilde bir davranış şekli içerisine girmeden her zaman sonuç odaklı davranın. Pozitif bakış açısıyla problemi giderme yollarına odaklanın.

şeyler kötü gittiğinde – ki bu noktada danışmanlık almaya daha eğilimliyizdir- önceden de kötü giden şeyleri hatırlamaya başlarız. BT danışmanlarına bazen, müşterileri çalışmalarından hiç memnun olmamış gibi gelir. Bu durum motivasyon kaybı yaratması sebebiyle çalışmaların da tam bir başarıya ulaşması konusunda bir engeldir. İnsan doğası iyi giden şeyleri hatırlamakta güçlük çeker. Böyle durumlara hazırlıklı olmakla birlikte, işinize hakim olduğunuzu hissettirin, soğukkanlı olun ve kimseyi suçlayıcı şekilde bir davranış şekli içerisine girmeden her zaman sonuç odaklı davranın. Pozitif bakış açısıyla problemi giderme yollarına odaklanın.

Bugüne kadar birçok büyük satın alımı bulunan HP, 25 milyar dolara Compaq şirketini satın aldıktan sonra 10.3 milyar dolar daha harcayıp yazılım üreticisi Autonomy’i bünyesine katmıştı. Satın alımdan bir yıl sonra Autonomy için çok para ödediğini belirten HP, sonrasında hem kendi şirketinden hem de Autonomy tarafından birçok kişiyi işten çıkarttı.

Bugüne kadar birçok büyük satın alımı bulunan HP, 25 milyar dolara Compaq şirketini satın aldıktan sonra 10.3 milyar dolar daha harcayıp yazılım üreticisi Autonomy’i bünyesine katmıştı. Satın alımdan bir yıl sonra Autonomy için çok para ödediğini belirten HP, sonrasında hem kendi şirketinden hem de Autonomy tarafından birçok kişiyi işten çıkarttı. Teknoloji tarihinin şüphesiz en çok ses getiren satın alım haberi Facebook’un 19 milyar dolar gibi rekor bir değerle WhatsApp’ı alması oldu. Bu satın alım, sadece 55 çalışanı olan ve kullanıcılarına bugüne kadar tek bir reklam dahi göstermemiş bir girişimin ne kadar başarılı ve değerli olabileceğinin kanıtıydı. Şüphesiz mesajlaşma uygulamaları arasında rakipsiz olan WhatsApp’ın gücü, Facebook için paha biçilemez durumdaydı.

Teknoloji tarihinin şüphesiz en çok ses getiren satın alım haberi Facebook’un 19 milyar dolar gibi rekor bir değerle WhatsApp’ı alması oldu. Bu satın alım, sadece 55 çalışanı olan ve kullanıcılarına bugüne kadar tek bir reklam dahi göstermemiş bir girişimin ne kadar başarılı ve değerli olabileceğinin kanıtıydı. Şüphesiz mesajlaşma uygulamaları arasında rakipsiz olan WhatsApp’ın gücü, Facebook için paha biçilemez durumdaydı. Dell’in EMC’yi satın alması, 67 milyar dolar ile teknoloji dünyasının en büyük satın alımı konumunda. Dell’in ismi depolama çözümleri konusunda bir dev olan EMC’nin satın alınmasından sonra Dell Technologies olarak değiştirildi. Bu satın alımla birlikte şirket depolama, server, sanallaştırma ve PC olmak üzere dört ana kolda faaliyetlerini yürütüyor.

Dell’in EMC’yi satın alması, 67 milyar dolar ile teknoloji dünyasının en büyük satın alımı konumunda. Dell’in ismi depolama çözümleri konusunda bir dev olan EMC’nin satın alınmasından sonra Dell Technologies olarak değiştirildi. Bu satın alımla birlikte şirket depolama, server, sanallaştırma ve PC olmak üzere dört ana kolda faaliyetlerini yürütüyor.

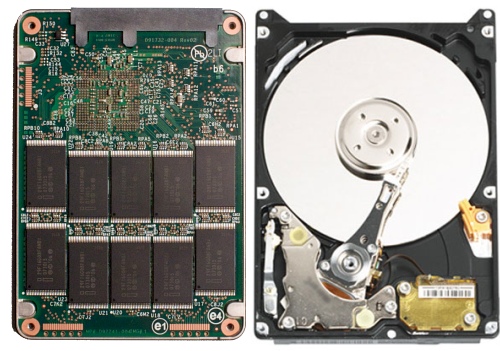

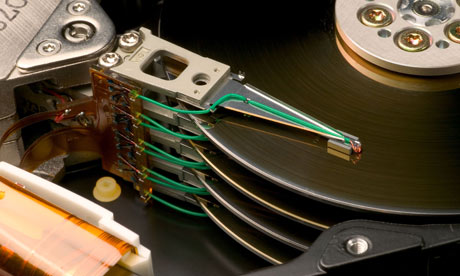

SSD olarak bildiğimiz katı sürücülerde ise diskin her yerine erişmek için harcanan zaman hem çok düşük hem de eşit olduğunda bu sürücülerdeki parçalanmanın herhangi bir etkisi yok. Zaten SSD’lerde birleştirme işlemi yapmak okuma yazma döngüleri oluşturacağı için sadece zarar yazacaktır.

SSD olarak bildiğimiz katı sürücülerde ise diskin her yerine erişmek için harcanan zaman hem çok düşük hem de eşit olduğunda bu sürücülerdeki parçalanmanın herhangi bir etkisi yok. Zaten SSD’lerde birleştirme işlemi yapmak okuma yazma döngüleri oluşturacağı için sadece zarar yazacaktır. Linux’ta neden olmuyor?

Linux’ta neden olmuyor?